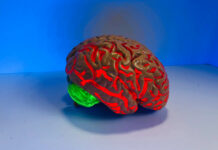

La neuromorphique consiste à s’inspirer du cerveau humain pour créer artificiellement des réseaux intelligents. Un exemple de bio-insipration qui pourrait à terme permettre le développement de réseaux performants et moins énergivores.

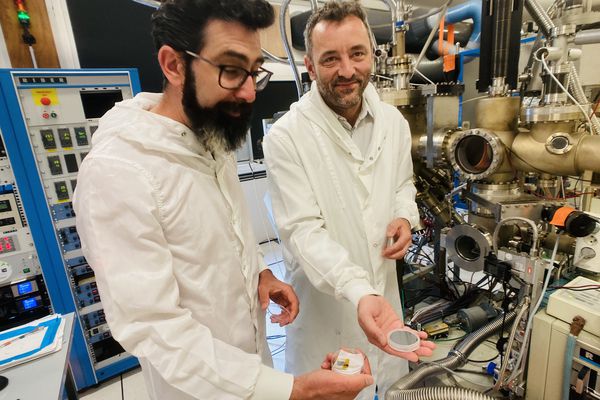

Damien Querlioz est chercheur au CNRS. Avec ses équipes, il tente de développer des systèmes intelligents reproduisant le fonctionnement des neurones et des synapses dans le cerveau. Le but ? Développer des modèles informatiques plus économes en énergie et donc plus performants.

Techniques de l’Ingénieur : Sur quels aspects s’inspirer du fonctionnement du cerveau pourrait améliorer les technologies existantes d’intelligence artificielle ?

Damien Querlioz : Ces dernières années ont été marquées par des progrès absolument considérables au niveau de l’intelligence artificielle. Aujourd’hui, dans certains cas, elle est capable de dépasser le cerveau en termes de performances. On en a eu l’illustration il y a quelques années lors de l’organisation d’un match de GO (le GO est un jeu de plateau) gagné par une intelligence artificielle (développée par Google), contre le meilleur joueur du monde.

Mais il y a d’autres aspects sur lesquels l’IA est bien moins performante qu’un cerveau. C’est le cas surtout en ce qui concerne la consommation énergétique. Pour revenir au jeu de GO, l’IA développée par Google tournait sur un énorme réseau d’ordinateurs et de cartes graphiques qui avaient une consommation électrique globale de 150 000 Watts. Pour le cerveau, on est à environ 20 Watts.

Cela illustre les différences de fonctionnement dans l’accomplissement de tâches intelligentes entre le cerveau et une IA. Nous essayons donc de développer une électronique qui reproduit les stratégies énergétiques opérant dans le cerveau.

Beaucoup de gens travaillent sur ces questions depuis quelques années car il s’agit là d’une vraie problématique de fond, mais également d’une problématique applicative, puisque la consommation énergétique élevée liée à l’usage de l’IA pose de vrais problèmes pour le futur, si on table sur un développement massif de cette technologie.

Comment s’explique ce fossé en termes de consommation énergétique ?

Aujourd’hui ce qui est assez clair, c’est que le facteur primordial expliquant la différence de consommation énergétique entre le cerveau et l’IA est la mémoire.

Dans un ordinateur, on trouve des processeurs spécialisés pour faire des mathématiques, et des mémoires où on stocke les informations. Les processeurs et les mémoires sont séparés non seulement physiquement mais aussi conceptuellement. On s’est rendu compte que dans les tâches d’intelligence artificielle, il n’y avait pas tant de mathématiques que ça à réaliser. Il s’agit plutôt de traiter des volumes de données énormes. En fait, la quasi-totalité de l’énergie dépensée est consacrée à déplacer des informations. Le cerveau, lui, a un fonctionnement complètement différent, puisqu’il ne sépare pas calculs et mémoire.

Dans le cerveau, l’équivalent des processeurs sont les neurones, et il est majoritairement admis que les synapses, qui connectent les neurones entre eux, sont les lieux de stockage de la mémoire. C’est l’énorme différence avec un ordinateur : dans le cerveau, les synapses se situent à la jonction entre les neurones, l’information est donc déjà sur place, là où on en a besoin. D’où un gain d’énergie phénoménal.

Le but de nos recherches est d’essayer de reproduire cette stratégie du cerveau en créant des circuits constitués de neurones artificiels et de synapses artificielles qu’on connecte au plus près les uns des autres, et qui seront capable de faire de l’IA en consommant beaucoup moins d’énergie.

Quels sont les contraintes liées à la conception de ces systèmes ?

Les neurones et les synapses artificiels peuvent être réalisés avec des transistors qui sont les composants traditionnels de l’ordinateur. Les chercheurs développent ces modèles-là depuis longtemps. Mais cela pose un gros problème. Dans un réseau de neurones, il y a énormément de synapses. Cela implique un nombre de transistors très élevé, une surface utilisée importante et un coût également très élevé. C’est pour cela que le nombre de synapses que l’on peut mettre sur une puce électronique est très limité.

De plus, les synapses réalisées avec des transistors ont le défaut d’oublier ce qui est mémorisé à partir du moment où l’on éteint la puce. Il est donc indispensable de reprogrammer toutes les synapses dès qu’on rallume la puce. Ce qui est très long et coûteux.

C’est la raison pour laquelle depuis plusieurs années beaucoup de recherches, dont la nôtre, se sont déportées sur le développement de nouveaux composants pour créer des synapses artificielles. C’est une petite révolution dans la microélectronique. Ces nouveaux types de mémoires, issus des nanotechnologies, sont particulièrement adaptés pour faire de l’intelligence artificielle. C’est un domaine qui est en train d’exploser.

Ces dernières années, nous avions dans les systèmes que nous développions quelques nano synapses. En ce qui concerne mon groupe de recherche, le système le plus abouti que nous avons mis en place comprenait 1024 nano synapses. A l’heure actuelle nous travaillons sur un système plus gros qui en contiendra 64 000.

Dans l’industrie aussi le sujet fait école, puisqu’ IBM a présenté lors d’une conférence à San Francisco en décembre dernier un système de plus d’un million de nano synapses !

Ce qu’il faut comprendre, c’est qu’à partir du moment où le système développé contient quelques milliers de nano synapses, il est déjà possible de développer des applications. Evidemment, quand on développe un système dépassant le million de synapses, les applications possibles sont d’autant plus complexes et ambitieuses.

Vous venez de nous parler de recherches qui s’inspirent du fonctionnement du cerveau. Que peut-on dire du fonctionnement des synapses et des neurones à proprement parler ?

Dans les travaux que je viens d’évoquer, on s’est inspiré de l’architecture du cerveau et de la manière dont les choses sont connectées. Mais dans nos expériences la fonction des neurones et des synapses reste assez différente de ce que font réellement des neurones et des synapses dans un cerveau.

Il y a un autre type de recherche, beaucoup plus fondamentale, qui vise à s’inspirer directement du comportement observé des synapses et des neurones dans le cerveau. Il faut savoir que les synapses et les neurones sont des objets très compliqués à étudier, qui ont une dynamique propre, et qui réagissent en temps réel selon des équations qui sont d’une grande richesse. Il est probable que cette dynamique soit utilisée par le cerveau, et qu’il y ait matière à s’en inspirer.

Le problème c’est que reproduire des objets dynamiques très riches à l’aide de transistors est très compliqué, au vu du nombre de transistors nécessaires.

Il s’agit là encore d’une autre gamme de recherche, sur laquelle je travaille en collaboration avec Julie Grollier à l’unité mixte CNRS/Thales, qui est un laboratoire coorganisé par le CNRS et la société Thales.

Nous utilisons pour ces recherches un autre type de nano composant, qui est un neurone artificiel. Il se présente sous la forme d’un petit objet qui a à la fois des propriétés électriques et magnétiques, et qui permet de reproduire les équations qui ressemblent à celles régissant le fonctionnement d’un neurone. A partir de là, nous avons réussi à fabriquer des petits réseaux de neurones et montrer qu’ils étaient capables d’effectuer des tâches, comme reconnaître des chiffres ou des voyelles prononcées.

C’est un domaine de recherche très excitant, puisqu’il s’agit là d’essayer de s’inspirer du fonctionnement du cerveau de la manière la plus profonde possible. Nous sommes encore dans une phase très amont de la recherche, et à l’heure actuelle notre démonstrateur comporte seulement quatre nano composants.

Le but ultime de ces recherches est-il de recréer artificiellement le fonctionnement exact du cerveau en laboratoire ?

Pas forcément. D’une part parce qu’aujourd’hui nous ne connaissons pas tout du fonctionnement du cerveau, déjà. Mais on touche là à un point fondamental. Pour effectuer une tâche intelligente, doit-on s’inspirer uniquement de la biologie ou doit-on s’inspirer également des technologies artificielles que nous possédons aujourd’hui ? Quelle est la meilleure approche ? Il me semble que la réponse à cette question n’a rien d’évident.

Posté le 20 mars 2020 par Pierre Thouverez dans Matériaux, Biotech & chimie